アンケート

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

- -

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

<ご質問:以下7つ>(1)(2)はいくつでも結構です。

(1)転職目的(転職をすることで実現したい事)

・

・

・

(2)企業に感じている魅力

・

・

・

(3)企業に対して気になっている点や懸念点

・

・

・

(4)転職時で実現したい年収(最低~希望)

・ 万円~ 万円

(5)転職時期※願望でも具体的なものでも何でも結構です。

・

(6)現状の企業への志望度合い

・

(7)併願企業の有無、優先順位

・

・

・

(8)上記の設問(1)~(7)へのご回答のうち、今回の応募先企業に伝えて良い項目を教えてください。

ご連絡いただいた以外の情報は応募先企業へお伝えしません。

※設問番号でお答えください(例:124678)

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

- -

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

日本法人を憎んでベトナム法人を憎まず

先述の最年少社員だけでなく、他の社員も自分への怒号はもちろん、反発、文句すら一切なかった。

やはり実施会社に来ても来なくても給与は減らなくしたのが大きいと思うが、その根底としてあくまでも自分はベトナム法人側、ベトナム人社員側の人間というスタンスを貫いていることが伝わっていると思う。

罪を憎んで人を憎まずという言葉があるが、日本法人を憎んでもベトナム法人内にいるメンバーを憎まないようになっているわけだ。

これがもし、自分は日本法人に直接雇用されており、ベトナム法人は腰掛であり、倒産は何事もなかったかのように日本法人の事務所で勤務だったらどうだろう。

間違いなく日本法人側の人間であるので、自分にすべての怒りが向けられることになっただろう。

また、自分も解雇されるうちのひとりであり、それはそれで大変だが、ベトナム法人にいるベトナム人社員のみんなを裏切ったみたいにならなかったのは誇らしい。

仕事は失っても、人間としての尊厳を失わなかった、卑怯な人間にだけはならなかったのがせめてもの救いだ。

会社倒産の経緯

勤務先倒産の正式な連絡を受けたのは2020年12月。

一応、書類上は2021年3月末をもっての倒産となるが、2021年1月には全員が会社都合(会社倒産)により解雇される。

なお、自分の勤務先は日本法人が親会社、ベトナム法人が子会社となっている。

また、今回ベトナム法人のみが倒産となるが、日本法人も経営状態は相当ひどいので、倒産まで秒読みと見ていいだろう。

そもそもの経緯は親会社から振り込まれるべきお金が期日までに振り込まれなかったことだ。それが2018年のことだったかな。

何度か連絡したが返事はない。数か月後になってやっと返事が来たが、半年間支払い不能で、その後今までの4分の1の金額しか払えないとのことだ。

その時点で会計事務所からもマークされ、危険を察知した社員から待遇のいい会社へ移っていった。

というのも、親会社からの振り込み状況が悪くなっただけではなく、従来自由に使えていた経費が親会社の監視により自由には使えなくなったのだ。

ベトナム法人なんて給与も安いし、それでも続ける理由は仕事があまりなく楽だから。

それと、見かけの給与が安くても経費が自由に使えれば税金のかからない給与をもらっているのと同じ。

そういううまみもあり、また勤務中に大学院の宿題ができるということで辞めずに続けることができた。

唯一、自分の汚点としては、退職を申し出た社員のうち、最年少の人間を引き留めてしまったことだ。

この時点で転職していれば憂き目を見ずに済んだのに、本当に申し訳ないことだ。

引き留めた理由は、この時点ではさすがに倒産はないだろうという楽観的な見方をしていたためだ。

逆に、この時点で自分も転職活動を始めておき、次の場所を確保しておいた方が良かったかもしれない。

にもかかわらず、いざ倒産が決まった時、この最年少社員からは感謝された。

理由としては、転職活動(面接)で外出する場合は有給休暇から差し引かないとする規定を作ったためだ。

この最年少社員は普段から有給休暇を使っていたので残り日数がなかったのだ。

もちろん、転職活動(面接)で外出したかどうか自分には確かめるすべはないし、いちいち会社名も聞かない。

事実上、倒産の日まで会社に来ても来なくても給与は減らないという体制を作り出した。

会社が倒産

今回は大学院とは全然違う話題。

自分は社会人入学ということで、会社に通いながら大学に通っているわけだ。

これは別に学校に規定として会社に通っていることが通学の条件ではないが、会社から給与が出ていて生活が成り立っているから大学に通う余裕があるということだ。

時間的には厳しいが、家賃など生活費は大学に通っていようといまいと同じなので気にする必要がない。

が、会社がなくなってしまえば収入のあてもないので、貯金を取り崩して生活はできるかもしれないが、無職で大学に通うのは無謀だろう。

そうなると単に転職活動をすれば済む話だが、どうせ転職するなら日本に行った方がいいのではないか。

この場合Trường Đại Học Bách Khoa Thành Phố Hồ Chí Minhには通えず、修士の学位もあきらめなければならない。

しかし、もう修士論文提案書も不合格となった以上、修士の学位が取れないことは明らかである。

なので、逆説的ではあるが何のしがらみもなく日本に帰れるという皮肉な結果となる。

なお、会社が倒産した時系列な経緯をここに書くかは迷った。

書かない方がいいとする理由としては、このブログはベトナムの大学院の話題であり、会社のことを書くと情報の粒度が下がるからだ。

だが、別に金をとっている有料のブログでもないし、情報の粒度が下がっても文句を言える人もいないだろう。

逆に、ここ書いた方がいい理由としては新しいブログの設立が面倒、というより複数のブログを管理する手間が面倒ということだ。

両者を天秤にかけると、わざわざ別ブログ立ち上げよりも、ここに書いた方が管理コストは少ない。

実際、Twitterのアカウントとか、何個かあるはずなのにどれもユーザー名とパスワードを忘れてしまった。

ログインはもちろん、自分の書き込みすらどうやったら出てくるのか分からない。

もっとも、Twitterはいろいろ問題もあるし、同じアカウントを1年以上使わないぐらいがちょうどいいけどね。

修士論文提案書

修士論文そのものの前に、修士論文提案書なるものを書くように指示があった。

これがHọc kỳ 1/2020-2021であり、在籍期間満了となるHọc kỳ 2/2020-2021で修士論文そのものが完了し、最大在籍年月の4年間を終える流れだ。

しかしこれを書いている2021年1月12日現在、修了はできないであろうことが分かってしまった。

その理由や経緯は後述、あるいは別エントリでの記載となるが、まずは時系列から。

時系列と言ってるそばから恐縮だが、いつだったか忘れてしまった。

たしか12月のどこかだったと思うが、4日ぐらいで修士論文提案書なるものを書くように言われる。

そして出来上がったものをメールで送ったり、実際に対面であったりして修正箇所を聞く。

で、12月末にはそれを大学院の情報科学研究科の受付に提出。

そして忘れもしない2021年1月7日(木)、13:00から発表会(いわゆる口頭試問、英語圏ではディフェンスと称する)の呼び出しを受けたが、当日9:51に情報科学研究科の受付からメールがあり、前倒しになったので今から来いという内容で合った。

メールを読んだ時点で10:30ぐらいだったので、そこから出発して11:00には学校についた。

でも結局前に発表する学生がいたので自分の番は11:30ぐらいからだったかな。

自分の発表が終わったのは12:00頃だったが、それで発表会そのものも終わった。

おや?自分の後にもう一人いたはずだが?

前倒しの連絡がいかなかったか、あるいは連絡を受けたが急だしこれなかったのか。

いずれにしてもその学生は自動的に修士論文提案書不合格となる不条理。

こんなことがあっていいのか。

なお、一旦全学生が部屋の外に出さされ、15分後ぐらいに結果発表。

他の学生がどうだったかわかりにくいが、自分は不合格。

この場合、あと1期しかないし、自動的に修了自体ができなくなるのではないだろうか。

また、これは後のエントリで書こうと思うが、それ以前の問題でそもそも学校に行けなくなる理由が12月時点で発生していた。

その後について

気が付いたら前回の更新から3か月が過ぎてしまったようで、「この広告は、90日以上更新していないブログに表示しています。」など書かれている。

更新がなかったから何の動きもないように思われるかもしれないが、実はこの3か月間で実に多くの動きがあった。

また、大学院に限らず、勤務中の会社でも大きな、そして全然好ましくない動きがあったのだが、ひとまずは更新の意思があることだけ書いておく。

修士論文の登録

セメスターとしてはHọc kỳ 1/2020-2021になるのだが、今期からはもう授業はない。

実は前セメスターであった組み込みシステムのさらに発展のような授業があったが、登録者は自分1名であり、当然5名に満たないので開講しなかった。

ふと、修士論文(厳密には報告科学)が全然進んでいないことに気づく。

登録は2017年12月に行ったが、その時サポートをしてくれることになった博士課程の学生ももういないのではないか。

そう思って先生にメールを送った。

本来なら論文以外の単位が全部とれた今年の5月ぐらいには送っておくべき立ったのが、新しい授業が始まったこともあって、そちらに注力していたのだ。

それを考慮しても8月には先生にメールしておけばよかったが、今は10月、まだ間に合うかもしれない。

そう思ってメールを送ったところ、速攻で返信が来た。

「もうインターネット上での締め切りも過ぎてしまったので、大学院事務局の担当者に直接会え」とのことであった。

実はその返信をもらったことに気づかず、返信を読んだのはその2日後だったが、読んだその日のうちに大学院事務局の担当者に会いに行った。

なお、場所はB3の115号室である。

すると、Form8と20を渡され、Form8はその場で記入し回収された。

Form20はA3の情報科学の担当者に渡すように言われた。

なのでその足でA3に向かい、一番入り口近くの職員に話しかける。

すると別な職員に代わり、その人の立ち合い及び先生の名前の厳密な綴りなどを代筆してもらい、Form20をその場で回収された。

これにより修士論文の登録は完了だという。

なお、2017年12月の時点での修士論文のテーマはベトナム語翻訳システムだったが、別なテーマになった。

当時の博士課程の学生ももういないであろうこと、さらにこの3年間でgoogle翻訳のベトナム語翻訳機能も充実してきて、わざわざ自分が研究するほどでもなくなってきたこともあるだろう。

新しいテーマは対話ロボットであり、もともとベトナム語の対話を想定していたようだが、自分がやることになったので日本語での会話ロボットとなった。

いらない雑誌accessで提灯記事

頼みもしないのに勝手に送られてくるスケッチプロというくだらない雑誌があったが、さいちゃんでも「これって誰得なんだろう」という川柳が読まれたほどで、あまりの無意味さに廃刊となった。

余計なものが来なくなってすっきりしていたが、いつのころからか同様の趣旨のaccessというのが送られてくるようになった。

当初はハノイリビングの不動産粗探し情報のようなものがあり、唯一それが役になっていたのだが、いつのころからかハノイリビングの不動産粗探し情報がなくなってしまった。

もはや読む価値もないのだが、先月号(厳密には8月号)に、コロナウイルスなので日本食レストランを食べて応援しようという趣旨の文章があり、それ自体は良いのだが、どういうわけか「駐在員が戻ってきて日本食レストランがなくなったらどう思うでしょうか?」というわけのわからない内容になっていた。

「知らねーよ」が正直なところだろう。

むしろ、在住者が普通に日本食レストランに行ったら目的地の店が倒産していたとかよくあるが、それこそ「どう思うでしょうか?」だろう。

というか、もともと接客が悪く、いずれ倒産するような店がこの機会にいよいよ消えてなくなっただけの話と思う。

接客がよく、もともと好きだった店をコロナウイルスで客足が減っているので応援するのなら分かる。

それを、そうでない店も日本食レストランだからという理由で助け合いとはならない。

と、言うのも、ホーチミンの日本人同士の人間関係はすこぶる悪く、もともと助け合いなんかない。

逆にだましあいとかで金銭的な被害が出たり、一般の人でも無視されたりとか冷たくあしらわれるとか精神的に嫌な目には合っているのではないだろうか。

と、access8月号のことで長くなってしまったが、今回の本題はaccess9月号だ。

何やらイベントの「取材」と題した記事があった。

このイベントを知らない人から見たら何とも思わないか、下手すればいいイベントとすら思われる危険性があるように思ったがもろにこの現場に居合わせた為一家言あるというか、苦言を呈さずにはいられない。

まず、このイベントは旅行をテーマにしており、それ自体は良いのだが、なぜか食べ物の屋台が出ていた。

で、そうなると予想できると思うが、それらのゴミが公園に散らかっていた。ものすごい悪臭であった。

にもかかわらず、accessでは悪臭のことが全然書かれていない。

また、accessではイベント終了後のことも書かれていた。

実際、イベント終了後数日たってもゴミはかたずけられず、悪臭が数日間続いていた。

にもかかわらず、accessでは悪臭のことが全然書かれていない。

驚くべきことに、「イベントは大成功であった」とすら書かれている。

とんでもない。イベントは大失敗である。迷惑極まりないイベントであった。

こうなると取材記事ではなく、ただの宣伝だ。

週間ベッターなんかも取材と称して単なる宣伝の記事が多くみられるが、こっちはまだ拒否できるというか欲しい人だけ取ればいいという雰囲気があるし、新しい飲食店情報は遊べるし一応役には立っている。

が、accessのもう終わったイベントを、しかも問題提起ならいざ知らず、あたかもイベントが成功したかのように書くことは問題である。

Học kỳ 2/2019-2020 総括

Học kỳ 2/2019-2020の総括。

と言っても今期は1科目しかないので、前回のエントリである「Hệ thống nhúng 成績発表」をもって総括としてもいいぐらいだ。

一応科目情報と学期情報を分けるという意味で総括は別エントリとした。

登録科目 1科目

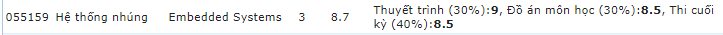

055159 Hệ thống nhúng Embedded Systems

登録単位:3単位

取得単位:3単位

単位取得率:100%

初年度は1と2の各学期で取れた単位が3単位であったので、むしろ初年度こそ3単位だけ登録し、そこに注力すべきだ。

なお、今期の授業を受けずともすでに論文以外の30単位を取得していたため、今期はもう授業はいらなかった。

にもかかわらず同科目を履修登録した理由は、組み込みシステムを学びたかったためである。

単位はなくてもいいので内容を知りたかったわけだ。

が、期待に反し授業らしい授業は3回ほどで、あとは自習となり、さらに在宅授業という名の自習。

最後の3回ほどはプレゼンテーションの場となったが、先生から直接何かを教えてもらう機会がほとんどなかったのが残念だった。

Hệ thống nhúng 成績発表

2020年8月26日、Hệ thống nhúngの成績発表が実施された。

最終試験が2020年8月21日だったので、本当にスピード採点だ。

中には最終試験から2か月ぐらいたってやっと成績発表という科目もあるのでこれはすごい。

なお、過去のエントリを見直すと、最終試験と期末試験が混在しているが、正式名称は英語名のFinal Examやベトナム語名のThi cuối kỳで統一されており、日本語の翻訳の問題である。

基本の学校だと期末試験が一般的だが、Finalを直訳して最終となったという、ただそれだけのことである。

さて、成績だが以下の通りである。

各10点満点中、プレゼンテーションが9点、ミニプロジェクトが8.5点、最終試験が8.5点だ。

割合をかけて総合すると最終的な成績は8.7点。

かなり点の取りやすい科目であったといえる。

ミニプロジェクトは自宅にあった掃除機を分解し、中の基盤の配電などを調べたりと手間がかかったが、その時間と労力が点数に反映されたという意味では努力が報われた科目である。

Hệ thống nhúng 最終試験

2020年8月21日、Hệ thống nhúngの最終試験が実施された。

同科目は中間試験がなかったので、これが唯一の試験である。

実は本記事入力時点において成績自体も出ているので、試験のことを書こうと思う前に結果が出るスピード採点であった。

さて、試験そのものだが、問題用紙に直接書き込む形式なので問題は回収されてしまった。

問題は全体の60%が四択もしくは2択で、全体の8割はEラーニングサイトと同じであった。

カンペを作っておいたのでその部分は正解であったと思う。

ただし、残り2割は見たこともない問題なのでTOEICのようにとりあえずなんか選んでおけば確率的には当たるかもしれないというもの。

全体の40%は記述式だが、ダイアグラム的なもので、こちらもスライドを印刷して持参したのでほぼ正解のはずだ。

なお参加者だが、学生は自分含め4名。うち1名は遅刻なので試験開始時には3名しかいなかった。

一方試験監督は2名もおり、学生に対する試験監督の割合は過去最高だ。なぜそんなに試験監督が必要なのか。

試験は70分であったが、50分ぐらいで終わったので1番乗りで退出。

この記事入力時点で点数が分かっており、10点満点中8.5点であった。

Hệ thống nhúng 12回目 最終回

2020年8月8日、Hệ thống nhúngの12回目授業が実施された。同日が最終授業となる。

一応既定の12回をこなしたことになる。実質の負担はせいぜい6回分ぐらいだが。

この日は土曜日なのだが、前日の金曜日の授業がなく、おそらく土曜日にずらしたということなのだろう。

自分を含め4名の学生が出席したが、オンラインは2名で、うっかり学校に行ってしまったのが2名。

メールが来たのが授業開始のわずか4時間前であったため、メールを読まずに学校に来てしまった学生がいても不思議ではない。

自分も久々に学校に行く気満々で機械などの準備をしていたが、念のためと朝8時ごろにメールを開いて愕然とした。

これで3年前同様、A3ビルディングでの授業に参加する機会は失われた。

さて、自分以外の3名のプレゼンテーションが終わった後、先生から「これで全員のプレゼンテーションが終わりました」の発言が。

自分はプレイステーション資料を前日に提出していたので、それを先生が読んでプレゼンテーションをしたのと同じとみなしたのだろうか?

万が一そうではなかった場合プレゼンテーション欠席となり得点が下がるので、ここでマイクをオンにして、プレゼンテーションをする旨を伝えた。

こうして自分は3回目となるプレゼンテーションを実施し、これで授業が終了。

試験は数週間後に実施され、A4版の紙の持ち込みだけが可能なようだ。

詳しい試験情報は後日メールで配信される。

Hệ thống nhúng 11回目

2020年7月31日、Hệ thống nhúngの11回目授業が実施された。

この日はコースプロジェクトのテーマについて概要を簡単にプレゼンテーションを行った。

さらに、翌週は最終のプレゼンテーションがあるという。

たった1週間でプレゼンテーションの資料を作るのは大変だ。

また、この翌日に授業を行うという予告もあったが、折しも中国を発生源とするコロナウイルスの影響によりなくなったようだ。

Hệ thống nhúng 10回目

2020年7月24日、Hệ thống nhúngの10回目授業が実施されたが、大分日数が経ってしまったので内容がどうだったか忘れてしまった。

プレゼン資料の日付がこの1週間後だから、おそらくこの日は翌週にコースプロジェクトのテーマをプレゼンするよう指示されたのだろう。

そして他の学生のプレゼンを聞いたようにも思えるが、記憶には残らなかった。

Hệ thống nhúng 9回目 やっと3名集まったオンライン授業もわずか20分で解散

2020年7月17日、Hệ thống nhúngの9回目授業が実施された。

この日は学生が自分を含めて3名集まったようで、18:23にはオンライン授業が始まった。

まあ授業といってもコースプロジェクトで各自何をするかを言って、18:40には全員解散となった。

ぶっちゃけ、授業をしていないに等しい。

過去ログを見ても、2020年6月12日に行われた5回目授業以降は授業らしい授業はなかった。